«Übersetze bitte diesen Text…» oder «Erstelle ein Brainstorming zum Thema …» sind in dieser oder ähnlicher Form beliebte Anweisungen, die die durchschnittlichen Anwender an ChatGPT übermitteln. Damit lassen sich fremdsprachige Amazon-Rezensionen übersetzen, Inspiration für Aufsätze einholen oder die Inhalte zu einem Marketingkonzept definieren. Dass die künstliche Intelligenz hinter ChatGPT ein hoch entwickeltes Sprachmodell darstellt und auf einer Datenbasis trainiert wurde, die quasi das Wissen der Menschheit bis zum Jahr 2021 enthält, ist vielen interessierten Nutzern bekannt. Aber wie funktioniert die Technik dahinter? Welche Wege mussten die Entwickler gehen, um die Fähigkeiten der KI so zu entwickeln? Machen wir einen Versuch, dies einfach und für Menschen verständlich zu erklären.

Training muss sein: So wird ChatGPT auf die natürliche Sprache getrimmt

Die Entwicklung eines Chatbots wie ChatGPT basiert auf dem Training des zugrunde liegenden Sprachmodells. So wie uns als Kind die Sprache antrainiert wurde, trainiert auch ChatGPT. Dieses Training erfordert eine immense Rechenleistung und kann Tage, Wochen oder Monate dauern. Ziel des Trainings ist es, dass die künstliche Intelligenz auf Eingaben in natürlicher Sprache sinnvolle Antworten erwidert. Um dies zu erreichen, kommen unter anderem Trainingsverfahren wie Unsupervised Learning und Word Embedding zur Anwendung.

Unsupervised Learning

Unsupervised Learning (unbeaufsichtigtes Lernen) vermittelt dem KI-Modell ein grundlegendes Sprachverständnis. Hierzu ist es nötig, Trainingsdaten mit unzähligen Schriftstücken zu verwenden. GPT wurde mit Büchern, Wikipedia-Artikeln, Webseiten und anderen Textquellen trainiert, um die menschliche Sprache in all ihren Facetten zu verstehen.

Word Embedding

Word Embedding basiert auf der Distributional-Hypothese (Wörter in ähnlichem Kontext haben eine ähnliche Bedeutung) und bildet Wörter mathematisch als Vektoren ab. Die Berechnung von Beziehungen zwischen Wort-Vektoren erlaubt es, Begriffe semantisch einzuordnen und ihre Bedeutung im Textzusammenhang zu erfassen. Die Worte «Auto» und «Fahrzeug» beispielsweise können synonym verwendet werden. Diese Tatsache hat das Sprachmodell gelernt, da die Begriffe oft zusammen in denselben Texten verwendet werden. Je grösser die Menge an Trainingsdaten ist, umso genauer ist die Ein- resp. Zuordnung jedes Wortes. Aufgrund des Trainings und der ermittelten Vektoren kann das Sprachmodell entscheiden und vorhersagen, welches Wort es als Nächstes schreiben soll. Auf diese Weise entstehen grammatisch und inhaltlich sinnvolle Sätze.

Die Infrastruktur dahinter: Alles aus der Cloud

Die fürs Training notwendige Rechenleistung bezieht ChatGPT aus der Cloud-Infrastruktur von Microsoft Azure. Hintergrund davon: Microsoft ging 2019 eine Partnerschaft mit der Firma OpenAI ein. OpenAI folgt der Vision, eine allgemein anwendbare künstliche Intelligenz (KI) zu schaffen, die der gesamten Menschheit zugutekommt. Mit dem Azure OpenAI Service stellt Microsoft die Möglichkeiten dieser künstlichen Intelligenz für die internen Projekte und als Dienstleistung für Geschäftskunden rund um den Globus bereit. Dazu sind bereits verschiedene Produkte wie der Microsoft 365 Copilot, der GitHub Copilot, Microsoft Teams Premium, Microsoft Viva Sales oder die Suchmaschine Microsoft Bing verfügbar. Sie interagieren mit Azure OpenAI Service und liefern, durch KI-Modelle unterstützt, Funktionen mit Mehrwert für den Azure-Kunden.

Menschenähnliche Fähigkeiten: Azure AI

Azure AI umfasst alle Dienste zum Betrieb von Anwendungen, die auf KI zurückgreifen. Es sind Dienste, die menschlichen Fähigkeiten ähneln: Spracherkennung, Sprachwiedergabe, Bilderkennung, Dinge Suchen oder die Fähigkeit Entscheidungen zu fällen. Diese Fähigkeiten werden allgemein als kognitive Dienste angeboten. Auch OpenAI ist ein solcher kognitiver Dienst. Sie können beliebig kombiniert werden. Alle nutzen sie Machine Learning um sich "fortzubilden".

Autonomes Fahren: So wird beispielsweise während dem Fahren gelernt

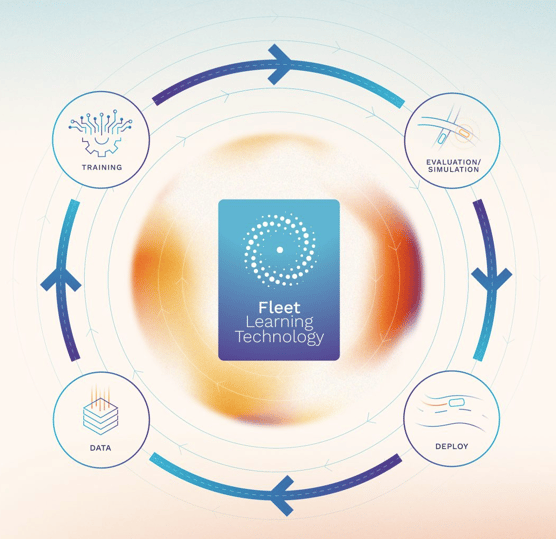

Ein nennenswerter Anwender, der Azure für seine eigenen KI-Modelle nutzt, ist das britische Unternehmen Wayve Technologies Ltd., das Technologien für autonomes Fahren entwickelt. Hierbei ist keine Sprachverarbeitung gewünscht, sondern das Training künstlicher Intelligenz mit Fahrdaten von Sensoren und GPS-Koordinaten sowie visuellen Informationen aus unzähligen Situationen im Strassenverkehr.

Die Autonomiesoftware von Wayve Technology Ltd. verbessert sich mit jedem gefahrenen Kilometer. (Bildquelle: Wayve Technology)

Die Autonomiesoftware von Wayve Technology Ltd. verbessert sich mit jedem gefahrenen Kilometer. (Bildquelle: Wayve Technology)

Kunden wie Wayve benötigen eine sehr flexible Skalierung der Cloud-Ressourcen in Azure, um kurzzeitig über viel Rechenleistung verfügen zu können. Die Hardware sowie die Verwaltung des Azure OpenAI Service sind darauf ausgelegt, schnell und variabel auf Kundenanforderungen zu reagieren. Hohe Rechenkapazitäten, Skalierbarkeit, Sicherheit und Datenschutz sind wertvolle Eigenschaften der Cloud-Dienste.

Geistiges Eigentum schützen: Datenschutz ist unabdingbar

Die Bereiche für künstliche Intelligenz verarbeiten sehr oft sensible persönliche Informationen oder Daten, die geistiges Eigentum enthalten. Obwohl herkömmliche Cloud-Umgebungen bereits nur verschlüsselt Daten übertragen und über Sicherheitsmechanismen verfügen, ist der Datenschutz trotz allem nicht vollständig gewährleistet. Cloud-Administratoren hätten innerhalb der Umgebung sehr wohl die Möglichkeit, Einblick in persönliche Informationen zu nehmen.

Daher arbeitet Azure unter Verwendung des Confidential Computing. Hierbei liegen die Nutzerdaten nur innerhalb einer geschützten Umgebung unverschlüsselt vor, auf die ausschliesslich der befugte Anwender Zugriff hat. Ausserhalb davon haben nicht einmal die Cloud-Administratoren die Möglichkeit zur Entschlüsselung. So können mehrere Parteien sich zwar dieselben KI-Modelle teilen, um optimal zusammenzuarbeiten. Die Trainingsdaten dieser Modelle jedoch sind für jeden einzelnen Nutzer vertraulich und Fremden nicht zugänglich.

Schneller ist besser: Spezielle Hardware und Netzwerke

Azure OpenAI Service fusst auf einer weltweit verteilten Hardwarearchitektur, die aus leistungsfähigen NVIDIA-Grafikprozessoren (GPUs), TPUs (Tensor Processing Units) und unübertroffen schnellen InfiniBand-Netzwerkkomponenten besteht. Das schnelle Netzwerk, welches jeden Server mit einer Bandbreite von bis zu 3,6 Terabyte pro Sekunde anbindet, wird hierbei nicht zum Flaschenhals, sodass die Hardware ihre volle Leistungsfähigkeit entfalten kann.

GPUs übertreffen hinsichtlich Rechenleistung die Hauptprozessoren von PCs und Servern um ein Vielfaches. Sie sind stark auf parallelisierte Berechnungen ausgelegt und können so effizient mehrere Verarbeitungen gleichzeitig übernehmen. Das zeigte der Kryptomining-Boom, als virtuelle Währungen mit viel Rechenleistung und dem Einsatz von Grafikkarten gesammelt wurden.

TPUs sind noch speziellere Hardwareeinheiten, die für Matrixberechnungen beim maschinellen Lernen im Einsatz sind. Für diese Art von mathematischen Operationen verfügen sie über gezielte Optimierungen und finden in Serverclustern für künstliche Intelligenz Verwendung.

Die Ressourcen der Infrastruktur von Azure erlauben den Betrieb von KI-Modellen, die noch weit grösser als ChatGPT mit 175 Milliarden Parametern sind. Microsoft arbeitet etwa am Megatron-Turing-Sprachmodell mit 530 Milliarden Parametern und hat in Zukunft vor, weitere Projekte in Dimensionen jenseits der aktuellen Ausmasse zu verwirklichen.

Gegen Lernblockaden: Lastverteilung, Fehler- und Ausfallbehandlung

In einer grossen und globalen Server-basierten Umgebung wie Azure kann es jederzeit zu Ausfällen einzelner Komponenten kommen. Damit darunter nicht der Fortschritt eines monatelangen Trainingsjobs für ein KI-Modell wie ChatGPT leidet, wird die gesamte Infrastruktur von einem Verwaltungsdienst namens Project Forge gesteuert. Dieser legt ohne manuelle Eingriffe für jeden Trainingsjob regelmässig Sicherungspunkte an, bei denen sich im Bedarfsfall abgebrochene Verarbeitungen fortsetzen lassen.

Einen solchen Checkpoint kann Project Forge auch dazu verwenden, Jobs zu Zwecken der Lastverschiebung auf andere Servercluster, die sich nicht einmal in derselben Region befinden müssen, zu migrieren. Mit diesem Vorgehen erreicht die gesamte Infrastruktur eine ausgeglichene Verteilung der Rechenkapazitäten, sodass brachliegende und überlastete Bereiche sowie Engpässe vermieden werden.

Damit Gelerntes nicht vergessen geht: Feinabstimmung von KI-Modellen

Die grosse Stärke der GPT-Modelle ist neben ihrer Sprachverarbeitung die Fähigkeit, sich über nahezu alle Bereiche des irdischen Lebens unterhalten zu können, seien es medizinische Themen, Kochrezepte, technische Verfahren, Kindererziehung oder Programmieren.

Die Spezialisierung auf unterschiedlichste Themengebiete und die ständige Verbesserung von Modellen künstlicher Intelligenz liegt in deren Feinabstimmung begründet. Diese benötigt, ähnlich dem Training, Ressourcen in Gestalt von Rechenleistung und Speicherplatz.

Die intelligente Optimierung der Feinabstimmung hat bei Microsoft die Bezeichnung «Low Rank Adaptive» (LoRA). Das Verfahren berücksichtigt nur die Bereiche eines KI-Modells, die von den geplanten Änderungen betroffen sind. So wird in einem Beispiel nicht der Einsatz von 96, sondern nur von 24 GPUs nötig, ein Checkpoint belegt statt einem Terabyte nur 200 Megabyte Platz. LoRA ist zudem effizient in der Anwendung von Parametern auf bestehende Modelle, was die kontinuierliche Feinabstimmung wesentlich vereinfacht.

Neben einer schonenden Ressourcennutzung verhindert LoRA, dass dem Modell das Phänomen des «Overcoming Catastrophic Forgetting» widerfährt. Dies würde eintreten, wenn Gewichte, die die Fähigkeiten des Modells anpassen sollen, die gesamte Entscheidungsfindung so beeinflussen, dass es zu einem plötzlichen Vergessen kommt. Damit wäre jeder bisherige Fortschritt zunichtegemacht. Daher passt LoRA nur kleine Teilbereiche an, auf die sich die Spezialisierung auswirken soll.

Fazit

Optimierte Hardware, ausgeklügelte Trainingsverfahren, weltweit verteilte Rechenzentren, leistungsstarke Skalierungsmöglichkeiten und die Öffnung für Unternehmenskunden machen die Infrastruktur von Microsoft Azure zur idealen Plattform für Projekte aller Art zur Umsetzung von künstlicher Intelligenz.